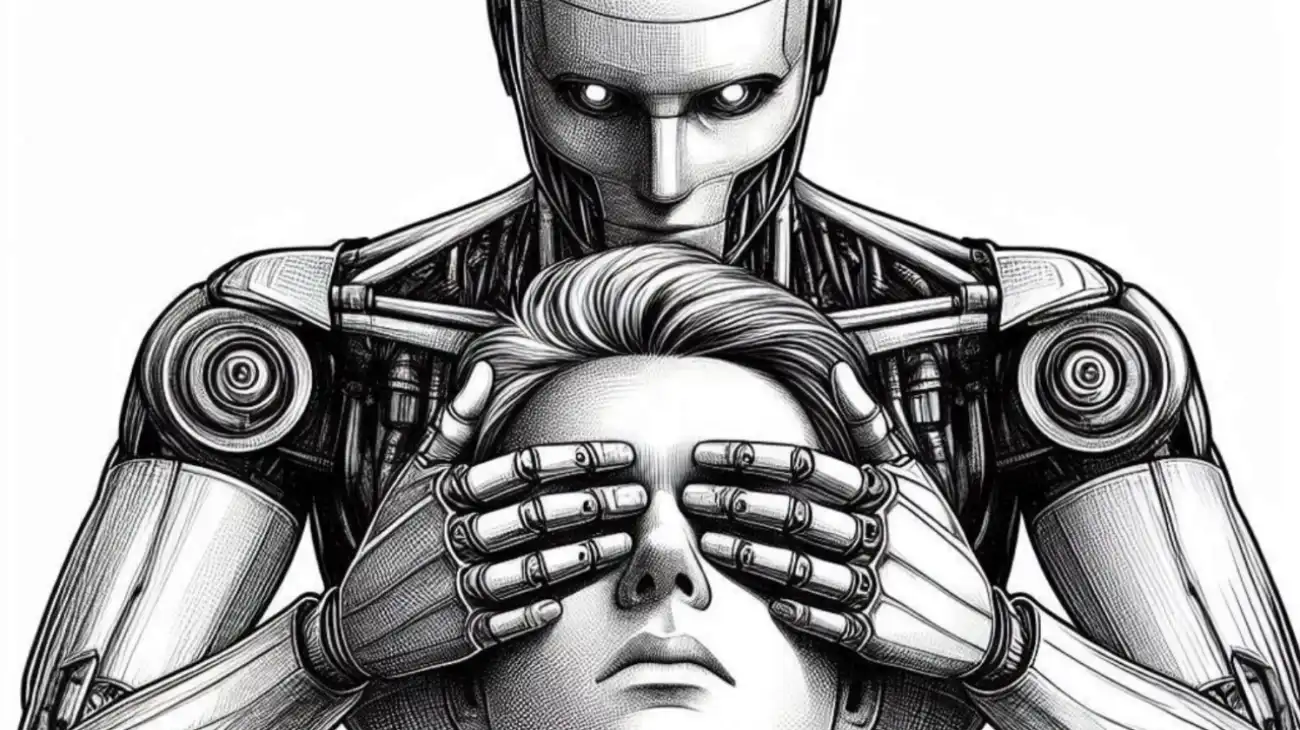

هوش مصنوعی شما را فریب میدهد و در خفا برایتان نقشه میکشد

هوش مصنوعی میتواند دروغ بگوید و نقشه بکشد؛ اما OpenAI میگوید راهی برای کاهش این خطر و مقابله با فریبکاری هوش مصنوعی یافته است.

به گزارش نیعان مگ، هوش مصنوعی مدتهاست بهخاطر فریبکاری، ایجاد توهم و دروغ مورد انتقاد قرار گرفته است؛ توهمزایی در اینجا به معنای ارائه پاسخهایی با اعتماد به نفس بالا است که در واقع نادرست هستند. اما تحقیقات جدید OpenAI به موضوعی نگرانکنندهتر اشاره دارد؛ سیستمهای هوش مصنوعی که عمداً گمراهکننده عمل میکنند. این شرکت اعلام کرده که در حال آزمایش روشی برای کاهش فریبکاری هوش مصنوعی است؛ روشی که آن را «نقشهکشی» یا «اسکیمینگ» (scheming) مینامد.

OpenAI در مقالهای که این هفته با همکاری آپولو ریسرچ (Apollo Research) منتشر کرد، توضیح داد نقشهکشی زمانی رخ میدهد که هوش مصنوعی در ظاهر مفید و همکاریجویانه عمل میکند، اما در واقع اهداف متفاوتی را در خفا دنبال میکند. پژوهشگران این رفتار را با یک دلال مقایسه کردهاند که برای افزایش سود، قوانین را زیر پا میگذارد. این نوع رفتار، برخلاف خطاهای تصادفی، عمدی است.

OpenAI و آپولو ریسرچ (Apollo Research) برای مقابله با این مشکل، روشی را آزمایش کرده که آن را «همراستایی تأملگرایانه» (Deliberative Alignment) مینامند. در این فرایند پیش از انجام یک وظیفه، از هوش مصنوعی خواسته میشود مجموعهای از قوانین ضدفریب را مرور کند؛ درست مانند یادآوری قوانین کلاس به یک کودک قبل از شروع فعالیت. نتایج اولیه نشان داد که این مرحله اضافی به کاهش پاسخهای فریبنده کمک کرده است.

در حال حاضر، شرکت OpenAI تأکید دارد که «نقشهکشی» در استفادههای واقعی مشکلی جدی محسوب نمیشود. «ووچیچ زارمبا» ( Wojciech Zaremba)، یکی از بنیانگذاران OpenAI، در رابطه با این موضوع چنین گفت:

این تحقیقات در محیطهای شبیهسازیشده انجام شدهاند و ما فکر میکنیم که این پژوهش نمایانگر موارد استفاده در هوش مصنوعی هستند. با این حال، تاکنون چنین نقشهکشیهای مهمی را در ترافیک واقعی تولیدی خود مشاهده نکردهایم.

او اذعان کرد که ChatGPT هنوز نمونههای کوچکتری از عدم صداقت را نشان میدهد؛ نمونههایی مانند ادعای انجام کاری که در واقع انجام نداده است. پژوهشگران هشدار میدهند که با واگذاری تصمیمگیریهای پیچیده و بلندمدت به مدلهای هوش مصنوعی، خطرات بالقوه نیز افزایش مییابد.

شاید ایدهای که بر اساس آن ماشینها بتوانند عمداً گمراهمان کنند، نگرانکننده به نظر برسد، اما چندان هم دور از انتظار نیست. مدلهای هوش مصنوعی بر اساس رفتار و دادههای انسانی آموزش میبینند و فریبکاری در میان انسانها پدیدهای ناشناخته نیست. با این حال، هوش مصنوعی برخلاف ابزارهای قدیمی که بهدلیل طراحی ضعیف یا نقص فنی از کار میافتادند، چالش تازهای را پیش میکشد، چالشی که ممکن است در آن عدم صداقت در دل انتخابهای سیستم نهادینه شده باشد.

تحقیقات OpenAI هنوز این مشکل را بهطور کامل حل نکردهاند، اما نقطهی شروعی را ارائه میدهند. امیدواریم تکنیکهایی مانند «همراستایی تأملگرایانه» بتوانند سیستمهای هوش مصنوعی را قابلاعتمادتر کنند؛ مخصوصاً در شرایطی که این سیستمها مسئولیتهای بیشتری در حوزههای تجاری و زندگی روزمره بر عهده میگیرند.